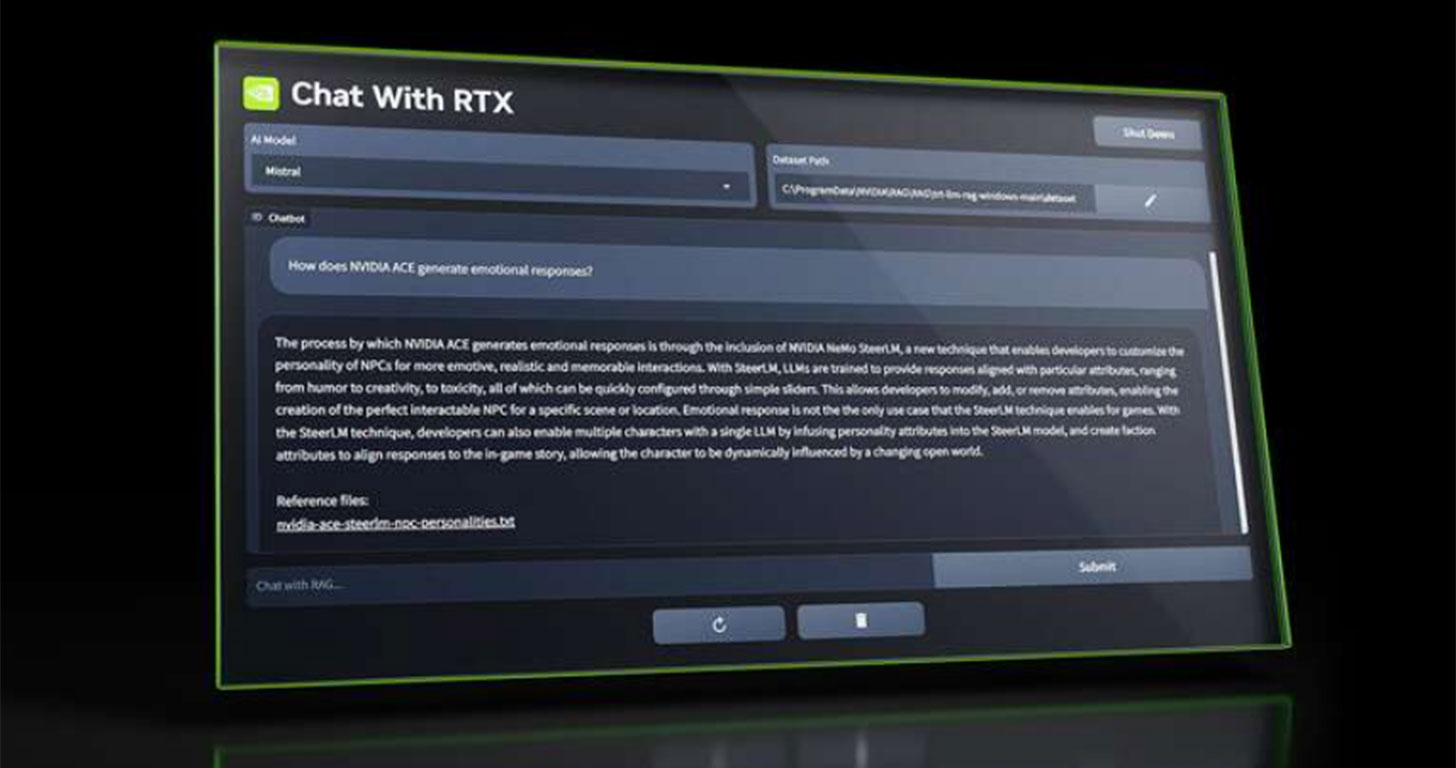

想要在自己的電腦上佈建類似 ChatGPT 的聊天機器人服務嗎?若你使用的是 NVIDIA 的高階 GPU,不妨可以關注一下 NVIDIA 日前發佈了適用於 Windows 作業系統的「Chat With RTX」,只要使用的是 GeForce RTX 30 或 RTX 40 系列顯示卡,即可在本機運行 Llama 2 和 Mistral 兩種大型語言模型(LLM),並能回答關聯至應用程式內容的查詢,包括文件、照片和影片…等,也能載入 YouTube 影片的轉錄,並使用它來回答與影片相關的內容。

你可能會有興趣

- 【FUJI按摩椅評價】五款產品試坐體驗、分析與推薦分享

- 【2025 最新】人體工學椅選購推薦!六大品牌評比一次看!

- 買電競螢幕前先等等!選購攻略看這裡!

- 買前必看!大型按摩椅選購/推薦/體驗心得深入解析

- 大家都在用的 Surfshark VPN 下殺 12 折!再送 4 個月免費訂閱!

本地端佈署大型語言模型的聊天機器人將更為容易

「Chat With RTX」可讓我們在本地端的電腦運行 LLM,不需要連結網路,NVIDIA 也標榜這個應用提供快速且安全的回答。不過 NVIDIA 也提到,Chat With RTX 目前只是一個「演示」版本的應用程式,且為免費提供給使用者,而檔案大小高達 35GB,可直接從 NVIDIA 的官方網站下載使用。

Chat With RTX 是同類型語言模型用應用中的首個開放程式,讓一般人也能輕易取得 LLM,並藉此開發更多元的應用,而未來 NVIDIA 也能基於這個程式推出許多其他功能,發展潛力不小。自從 OpenAI 推出 ChatGPT 以來僅一年半的時間,我們已經在「生成式 AI」的世界中看到更多創新,毫無疑問,這也將會是未來科技領域發展的重要方向。

什麼是 Chat With RTX?

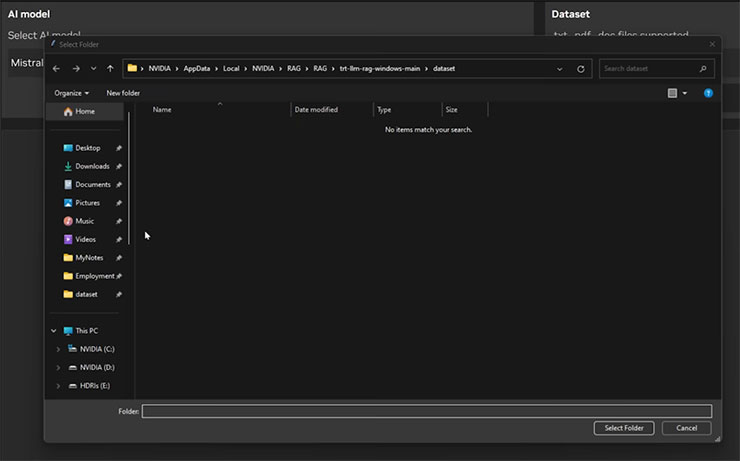

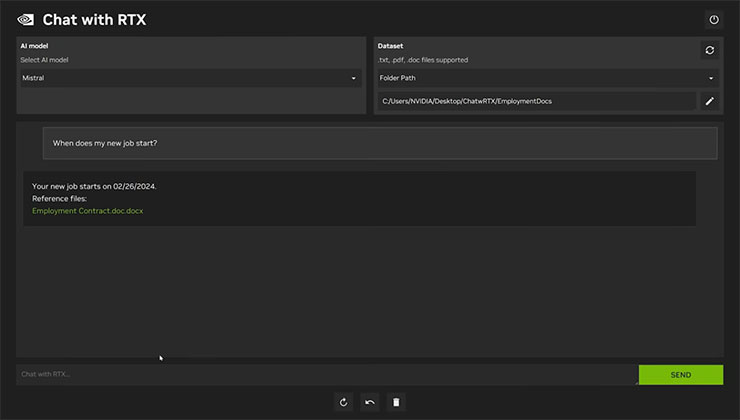

Chat With RTX 是一款演示應用程式,可以透過個人化方式連結到自己的內容,包括文檔、筆記、影片或其他數據的 GPT 大語言模式(LLM),並能透過檢索增強生成(RAG)、TensorRT-LLM 和 RTX 加速,並能查詢自訂聊天機器人,以快速獲得上下文的相關答案。由於它全部在你的 Windows 電腦或工作站本地運行,因此更能獲得快速、安全的結果。

Chat With RTX 系統需求

- 平台:Windows 11

- 圖形處理器:NVIDIA GeForce RTX 30 或 40 系列 GPU 或 NVIDIA RTX Ampere 或 Ada Generation GPU,具有至少 8GB VRAM

- 記憶體:16GB 以上

- 驅動程式:535.11 以上

你可能會有興趣

- 【FUJI按摩椅評價】五款產品試坐體驗、分析與推薦分享

- 【2025 最新】人體工學椅選購推薦!六大品牌評比一次看!

- 買電競螢幕前先等等!選購攻略看這裡!

- 買前必看!大型按摩椅選購/推薦/體驗心得深入解析

- 大家都在用的 Surfshark VPN 下殺 12 折!再送 4 個月免費訂閱!

相關連結:

Nvidia Chat with RTX lets you run LLMs locally on RTX 30 and 40 series GPUs – SamMobile

Build a Custom LLM with Chat With RTX | NVIDIA

歷史上的這一天,我還寫了…

- 遠傳電信與愛立信攜手於 MWC 2025 展示臺北大巨蛋 5G-Advanced 差異化連接服務,改善大型活動網路卡頓痛點! - 2025

- OPPO 首款摺疊機 Find N2 Flip 正式登台,百變摺學挑戰最強!同步推出 Enco Air3 真無線耳機與 Pad Air 平板! - 2023

- 晶片荒持續不斷?連機車也供不應求!KYMCO 執行長呼籲「有車就買」! - 2022

- Intel EVO 版 Acer Swift 5 開箱實測:既纖薄又堅固,搭載 Intel 第 11 代處理器,效能不只強悍更兼具全日續航力! - 2021

- 超窄邊框 4K IPS 廣視角,最超值的 Philips 276E8VJSB/96 27 吋螢幕開箱!同場加映 NB FP-1 螢幕壁架介紹! - 2020

- Galaxy S20 系列三款新機,最多人選擇的是…? - 2020

- [Mobile] 華為品牌體驗服務店插旗高雄!新堀江店盛大開幕吸引近千名粉絲排隊搶好康! - 2019

- [Unbox] 不到千元!小米生態鏈企業出品「70邁智能行車記錄儀」開箱實測! - 2018

- [Event] 人氣美食旅遊部落客「爆肝護士」攜手天母商圈52家異國特色美食餐廳打造「天母美食祭」,除了吃美食更有大獎等你來拿! - 2017

- [Video] 三星印尼Youtube頻道曝光Galaxy S7功能展示影片,已確認具備防水功能… - 2016

![[Mobile] 回顧 2018 年智慧型手機的發展:六個市場主流趨勢,你的手機有跟上嗎? - 阿祥的網路筆記本 [Mobile] 回顧 2018 年智慧型手機的發展:六個市場主流趨勢,你的手機有跟上嗎? - 阿祥的網路筆記本](https://axiang.cc/wp-content/uploads/thumb_20200809181851_81.jpg)

![[Event] 「生而行動,盡顯龍耀」高通媒體之夜活動記實! [Event] 「生而行動,盡顯龍耀」高通媒體之夜活動記實!](https://i1.wp.com/axiang.cc/wp-content/uploads/qcm001.jpg?resize=232%2C155&quality=90&zoom=2)

無留言